隨著人工智能技術的迅猛發展,關于其潛在威脅的討論日益激烈,尤其是在人工智能基礎軟件開發領域。這一爭議不僅牽涉技術安全問題,更觸及倫理、就業和社會結構等多個層面,成為全球科技界與公眾關注的焦點。

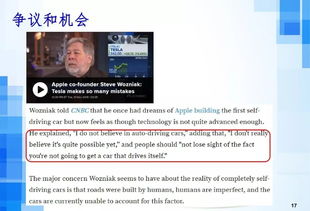

一方面,支持人工智能威脅論的觀點指出,基礎軟件作為AI系統的核心,其開發若缺乏有效監管,可能導致不可控的風險。例如,自主決策系統的錯誤或被惡意利用可能引發重大安全事故;算法偏見可能加劇社會不公;而高度自主的AI甚至可能超越人類控制,威脅人類社會穩定。這些擔憂促使許多專家呼吁在基礎軟件開發階段嵌入嚴格的倫理框架和安全機制。

另一方面,反對威脅論的聲音強調,人工智能基礎軟件的開發正通過透明化設計、多方協作和持續測試來降低風險。開源社區和跨國公司的共同努力,已推動了許多安全標準的建立。AI在醫療、教育和環保等領域的積極應用,證明了其潛力遠大于威脅。關鍵在于人類如何引導技術發展,而非技術本身。

在基礎軟件開發的具體實踐中,爭議往往集中于數據隱私、算法公平性和系統魯棒性。開發者需平衡創新與責任,例如通過可解釋AI技術增強透明度,以及構建抗攻擊的軟件架構。政策制定者正逐步出臺法規,如歐盟的AI法案,以規范開發流程。

人工智能威脅論的最大爭議并非否定技術進步,而是如何確保基礎軟件開發以人為本。通過跨學科合作、倫理教育和全球治理,我們有望將AI轉化為推動社會進步的強大工具,而非不可控的威脅。持續對話與迭代優化將是化解爭議的關鍵路徑。